Neue Zusammenhänge erschließen – Erkenntnisgewinn aus Bilddaten mit Methoden des maschinellen Lernens

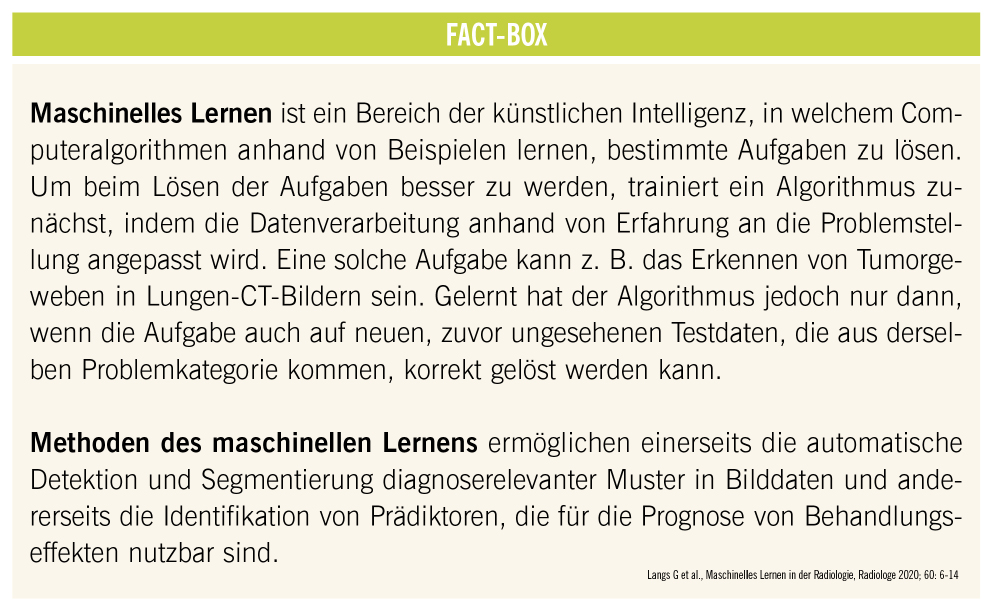

Was ist, wenn Digitalisierung nicht nur ein Trend, sondern eine Revolution ist, die jeden Lebensbereich trifft – nur gefühlt nicht jeden eigenen Lebensbereich? (1 Punkt) Was ist, wenn künstliche Intelligenz, „machine learning“, eine Schlüsseltechnologie des 21. Jahrhunderts ist – nur einem selbst fehlt der Schlüssel? (2 Punkte) Ab einem Score von 2 Punkten fragt man Spezialisten wie Professor Georg Langs von der MedUni Wien, der als Leiter der Abteilung „Computational Imaging Research Lab“ an der Universitätsklinik für Radiologie und Nuklearmedizin arbeitet. Schwerpunkte sind: „Machine Learning & Neuroimaging“, „Computer Aided Diagnosis and Quantification“ sowie „Computer Vision and Pattern Recognition“. Es geht um das Auswerten von Mustern aus Bilddaten (CT, MRT) im Kontext klinischer Informationen mit Methoden des maschinellen Lernens. Ziel ist Unterstützung bei Diagnose, Behandlung (Prädiktion) und Verlauf (Prognose). Wir haben uns für ein Interview entschlossen, das die erwähnten Schwerpunkte nahebringen kann.

Assoc. Prof. Dipl.-Ing. Dr. Georg Langs: Wir sind Teil der Universitätsklinik für Radiologie an der MedUni Wien und beschäftigen uns mit der Entwicklung von Methoden im Bereich des maschinellen Lernens. Der erste Ansatz hat als Diagnoseunterstützung begonnen, d. h., der Versuch war, computergestützt in Bilddaten Marker zu finden, die man kennt, und diese zu vermessen. Wir haben etwa bei rheumatoider Arthritis begonnen, Läsionen zu detektieren und zu quantifizieren und dann in anderen Zusammenhängen wie Brustkrebs im Sinne gutartig vs. bösartig zu klassifizieren – um damit in Zukunft vielleicht unnötige Biopsien vermeiden zu können. In den letzten Jahren hat uns zunehmend interessiert, ob wir dieses Markervokabular erweitern können. Wir arbeiten mit diffusen Lungenerkrankungen, Lebererkrankun- gen, mit Neurobildgebung, um zu zeigen, ob man z. B. ursächliche Areale bei Epilepsie identifizieren oder quantifizieren kann, welche Umbauprozesse im Gehirn stattfinden, wenn ein Tumor wächst.Eine Motivation unserer Arbeiten besteht darin, nicht mehr nur zu fragen, ob ich einen bestimmten Marker im Bild entdecken kann, von dem ich bereits eine diagnostische oder prognostische Erwartung habe, sondern ob ich neue Marker identifizieren kann, indem wir mit ausreichend Daten unterscheiden können zwischen physiologischem Gewebe oder kleinen Läsionen, diffusen Veränderungen, die hervorstechen, sich verändern oder anders aussehen, und damit schließlich Kandidaten für Surrogate des Krankheitsfortschritts sind. An der MedUni Wien sind wir Teil einer Klinik und haben selbst Mediziner in der Gruppe. Für uns Techniker ist das eine wichtige Voraussetzung, um zu verstehen, was überhaupt relevant ist, und sobald Kliniker ein Gefühl dafür bekommen, was potentiell möglich ist, ergeben sich wesentlich interessantere Themen. Allein schon die Suche nach Anomalien ist nicht primär ein technisches Repertoire, für Medizinier aber alltäglich, die sagen, es gibt in den Bildern allerhand zu sehen, was noch keinen Namen hat, aber trotzdem mit der Krankheit zusammenhängen kann, und mit Methoden des maschinellen Lernens identifiziert werden kann. In einer zweiten Stufe kann man mit klassischen statistischen Methoden testen, ob diese Muster auch wirklich mit der Zukunft des Patienten zusammenhängen wie z. B. mit der Wirkung einer Behandlung. D. h., am Schluss steht oft nach wie vor eine Zahl mit einem p-Wert und Genauigkeitsintervall. Daran kann eine Studie angehängt werden.

Mich hat anfangs überrascht, dass Ärzte sehr am „unsupervised learning“ interessiert sind, an der Entdeckung neuer Muster, die nicht denen entsprechen, die man bereits kennt oder die bereits im diagnostischen Repertoire vertreten sind. Vielleicht sind sie schwer zu beschreiben oder mit freiem Auge zu erkennen, hängen aber in letzter Konsequenz vielleicht klarer z. B. mit der Progression der Erkrankung zusammen.Supervised learning: Bei überwachtem Lernen trainieren wir ein Modell (z. B. ein Random-Forest- oder ein Deep-Learning-Modell) anhand von Beispielen, die aus Paaren einer Beobachtung (Input) und eines Zielwerts (Output) bestehen: Etwas wird eingegeben, z. B. das Bild einer Läsion, und es kommt ein Wert heraus: gutartig oder bösartig. Das Trainingsset besteht beispielsweise aus anhand von Biopsien bestätigten Bilddaten. Falls die Vorhersage des Modells auch neuen Bilddaten der Biopsie entspricht, ist das Evidenz für ein valides Modell. Unsupervised learning: Unüberwachtes Lernen heißt, es gibt Strukturen in den Daten, die der Computer selbst wiederholbar entdecken kann. Der Gedanke dahinter ist, dass sich bestimmte Bildkategorien zwar erklärbar beschreiben lassen, diese aber nicht notwendigerweise das Beste sind, was sich aus Bildern herausholen lässt. Mit dem Instrument des maschinellen Lernens kann man vielleicht auch andere Muster in den Bilddaten beschreiben bzw. verlässlich und wiederholbar extrahieren, die aktuell noch keinen Namen haben, aber biologisch vorhanden sind und Spuren der Krankheit oder der Wirkung einer Behandlung im Bild zeigen. Interessant dabei ist, ob auf Basis solcher Muster bestimmte Patientengruppen identifiziert werden können – etwa im Sinn einer neuen Diagnosegruppe, einer genaueren Charakterisierung der Erkrankung mit Patienten, die ein bestimmtes Ansprechverhalten zeigen. So bieten sich unsere Arbeiten als Werkzeug dafür an, um diagnostische Kategorien erweitert oder neu zu denken.

Wir beschäftigen uns mit funktionellen Netzwerken im Gehirn und beobachten diese mit Hilfe von funktioneller Magnet-resonanztomographie: Das ist eine Modalität, mit der man mittlerweile schneller als im Sekundentakt das BOLD-Signal messen kann, das von lokaler Oxygenierung abhängt – d. h., mittelbar kann man beobachten, wieviel Energie wo im Gehirn verbraucht wird. Wenn man das für alle Punkte im Gehirn weiß, kann man die sehr niederfrequenten Schwingungen dieses Signals beobachten, und deren Korrelation als Zeichen einer Verbindung sehen. D. h., wenn zwei Punkte im Gehirn immer synchron miteinander Energie verbrauchen, dann dürfte zwischen diesen Punkten eine Verbindung bestehen. Das ist in Kontrollpopulationen gut studiert, d. h., oft beginnen die Untersuchungen nicht nur direkt krankheitsassoziiert, sondern auch grundlagenwissenschaftlich, um die Architektur des Gehirns zu verstehen, von der ausgehend wir die Auswirkungen von Krankheit messen. Wir untersuchen z. B., wie solche Verbindungen bereits vor der Geburt in utero aufgebaut werden und wie sie ganz natürlich zwischen Menschen variieren. Eine Beobachtung ist nun, dass Gehirntumoren funktionelle Areale, wie z. B. Sprachareale, teilweise zerstören, die Fähigkeit zur Sprache aber erhalten bleibt. Die Hypothese zum Erhalt dieser Fähigkeit ist, dass – bei langsam genug wachsenden Tumoren – das Gehirn die Kapazität hat, sich zu reorganisieren, indem ein anderes Gebiet die Rolle des ursprünglichen übernimmt. Ein hochinteressantes Thema, über das wir noch nicht genug wissen. Können wir z. B. nachverfolgen, welche Wanderbewegungen wohin stattfinden, denn wenn die neue Region die Aufgabe der anderen erfolgreich übernimmt, müsste ja auch das Verbindungsnetzwerk mitziehen, um weiterhin mit den Kooperationspartnern kommunizieren zu können. Wenn wir also Netzwerke, die wir kennen, an neuen Orten finden, ist das ein Zeichen, dass Reorganisation stattgefunden hat. Die Umbauprozesse sind oft sehr großflächig und es gibt Unterschiede, welche Regionen dazu mehr oder weniger in der Lage sind. Damit sind wir wieder bei der Grundlagenwissenschaft, und versuchen zu verstehen, ob die Kapazität einer Region, sich zu reorganisieren, mit ihrer ganz natürlichen Variabilität zwischen Menschen und vielleicht mit ihrer Entstehung bei der Gehirnentwicklung zusammenhängt. Eine interessante Beobachtung war, dass wir in einigen Fällen funktionelle Veränderungen der Netzwerke schon sehen, bevor in der strukturellen Bildgebung Läsionen sichtbar werden. Das kann bei Rezidiven relevant sein.

Die ersten Anwendungen befassen sich recht erfolgreich mit Detektion, also mit einem kleinen Teil dessen, was maschinelles Lernen kann. Die Unterstützung komplexer Diagnose ist noch am Anfang. Prinzipiell muss man vorausschicken: Der Wettbewerb Mensch gegen Maschine hat eigentlich aufgehört. Wenn früher spannende Anwendungen auf einem Basis-Prototyp-Level auf Kongressen vorgestellt und mit der Erwartung, unmittelbar vor der Anwendung zu stehen, begeistert kommentiert wurden, dann ist diese Euphorie mittlerweile einem deutlich nüchterneren und informierteren Zugang gewichen: Vielleicht auch aufgrund eines besseren Verständnisses darüber, wie schwierig die Problemstellungen sind, aber v. a. weil die technischen und medizinischen Experten viel enger zusammenarbeiten und einige Anwendungen den Schritt zum Medizinprodukt bereits vollzogen haben. Da darf man kritischer werden.Die erste Stufe dreht sich um das Quantifizieren dessen, was ich am Bild sehe, um Merkmale zu extrahieren und dem befundenden Arzt zur Verfügung zu stellen: Läsionen detektieren, zu vermessen und gutartig/bösartig zu erkennen. Dazu gibt es Produkte in der ersten Version, die man zur Diagnose verwenden kann. Man hat in der frühen Phase diskutiert, ob all das die Ärzte im diagnostischen Bereich ersetzen wird. Mittlerweile ist klar geworden, dass dem nicht so sein wird. Automatisierung wäre ja bis zu einem gewissen Grad das Einfrieren des Status quo und das wäre, unabhängig davon wer besser ist, eine starke Einschränkung. Stattdessen können bei der Entscheidungsfindung für einen Patienten Diagnostiker zusammen mit Algorithmen etwas Relevantes bieten: Der Algorithmus gibt Konfidenz, kann Unsicherheiten klären, und v. a. neue vorhersagekräftige Muster identifizieren und für individuelle Patienten nutzen. Statt dass eine Maschine die Diagnose alleine erstellt, verschiebt sich die Einschätzung in Richtung „unterstützend“ und bildet so die Realität besser ab. Was daher besonders spannend ist, sind Vorhersagemodelle: Kann ich für Patienten mit bestimmten Voraussetzungen individuelles Risiko und Responseverhalten schätzen, um zu beantworten, welche Therapie am besten ist? Diese Entwicklung läuft.

Wir sehen mehr und mehr Projekte auch von unserer Seite, die nicht mehr nur von diagnostischen Produktherstellern unterstützt werden, sondern von der Pharmaindustrie, die sich dafür interessiert, ob wir anhand früher biologischer Veränderungen ein Responseverhalten bereits nach kurzer Therapie-dauer vorhersagen können, ob wir Responderprofile in den Daten identifizieren können. Es wäre für Studien interessant zu wissen, ob es Sinn macht, die Therapie noch weiterzuführen oder ob ein guter Zeitpunkt für einen Switch gekommen ist. Die Perspektive ist, dass man gemeinsam mit einem Medikament auch den Algorithmus hat, welcher Patienten dafür der richtige ist. Erste „Proof of Concept“-Planungen dazu sind am Laufen, und der Zeithorizont für solche Anwendungen in klinischen Studien? Es dürfte in einigen Jahren so weit sein.

Einer der großen Blocker ist der Zugang zu diesen Daten. Klar ist, dass solche Anwendungen durch eine Ethikkommission müssen und datenschutzkonform aufgebaut sein müssen. Wenn aber all das erfolgt ist, hat man immer noch keine Daten, weil die Infrastruktur dafür – v. a. für unbedingt notwendige multizentrische Studien – noch sehr heterogen ist und man sich durch viele individuelle Lösungen durcharbeiten muss. Große Initiativen, die das erleichtern würden, würden extrem schnell Fortschritt bringen – der meiner Erfahrung nach auch gewollt ist. Die Notwendigkeit, aus solchen Daten zu lernen, wird gesehen.

Ich denke, dass man bei häufigen Erkrankungen, die bei vielen ähnlich verlaufen, mit Modellen die Antwort liefern kann, die man braucht. Je mehr es zu seltenen Erkrankungen kommt, desto kleiner wird der Datensatz und eine robuste Vorhersage schwierig. Ich würde hier unabhängig von der Häufigkeit einer Erkrankung sagen: Der Schritt zurück zum biologischen Verständnis ist essentiell. Vorhersagemodelle sind ja auch nur ein identifizierter Zusammenhang zwischen dem, was ich beobachte, und dem, was später passieren wird. Der zweite Schritt muss daher zurück zur Biologie führen und fragen, was ist der Mechanismus? Daher beginnt sich das Feld auch in eine Richtung zu bewegen, die mithilfe maschinellen Lernens Bilder z. B. auch mit Epigenetik oder Methylierung verknüpft, um zu sehen, ob Veränderungen, deren Spuren wir in den Bilddaten messen können, mit einem Pathway zusammenhängen, der auf molekularer Ebene untersucht und dann verifiziert werdenkann. Ich denke, das ist ein Aspekt, der für seltene Erkrankungen relevant ist: Über Bilddaten einen Weg zu finden, Mechanismen zu verstehen.